在构建基于TensorFlow的服务器环境时,需综合考虑硬件配置、软件部署、性能优化及安全管理等多个维度,TensorFlow作为主流的深度学习框架,其服务器部署方案直接影响模型训练与推理的效率,硬件层面应优先选择支持CUDA的NVIDIA GPU,如A100、V100或RTX系列,利用GPU的并行计算能力加速矩阵运算,对于大规模训练任务,可采用多GPU分布式训练,通过NVLink高速互连技术提升GPU间通信带宽,同时配备大容量内存(建议128GB以上)和高速SSD,避免数据加载成为瓶颈,服务器操作系统推荐Ubuntu 20.04 LTS,因其对CUDA和cuDNN的支持更为完善,且社区资源丰富。

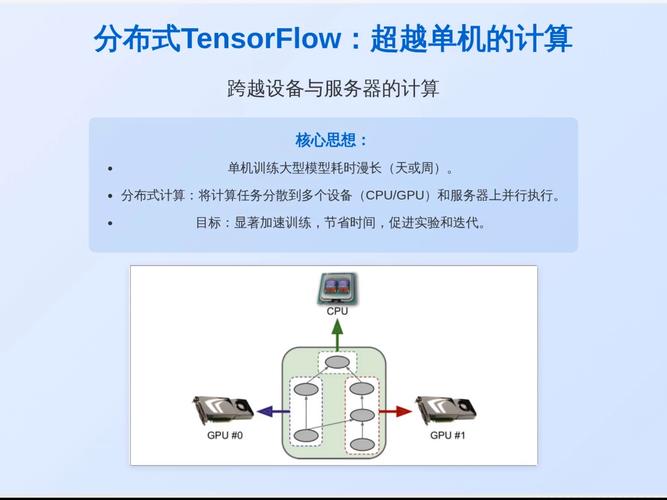

软件部署方面,需先安装NVIDIA驱动和CUDA Toolkit,确保版本与TensorFlow兼容(如TensorFlow 2.10对应CUDA 11.2),随后通过conda或pip安装TensorFlow,建议创建独立虚拟环境以避免依赖冲突,对于分布式训练,可采用TensorFlow的tf.distribute.Strategy模块,如MirroredStrategy适用于单机多GPU,MultiWorkerMirroredStrategy支持多机多节点协同训练,需配置Kubernetes(K8s)或Docker进行容器化部署,实现资源隔离与弹性扩展,例如通过NVIDIA GPU Operator自动管理GPU资源。

性能优化是关键环节,需从数据加载、模型计算和通信三方面入手,数据加载可采用tf.data.Dataset API,结合prefetch和interleave机制减少I/O等待时间;模型层面,使用混合精度训练(tf.keras.mixed_precision)可显著降低显存占用并提升计算速度;分布式训练中,需合理设置all_reduce算法(如NCCL或Ring All-Reduce),优化节点间通信效率,监控工具如TensorBoard或Prometheus+Grafana可用于实时跟踪GPU利用率、内存占用及训练指标,及时发现性能瓶颈。

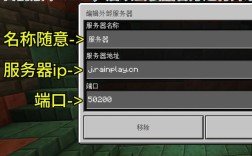

安全管理同样不可忽视,服务器应配置防火墙规则,限制非必要端口访问,启用SSH密钥认证并禁用密码登录,对于敏感数据,可采用TensorFlow的加密功能(如tf.EncryptedTensor)或在数据预处理阶段进行脱敏处理,定期更新系统补丁和依赖库版本,避免已知漏洞被利用,若需远程访问,建议通过VPN或内网穿透工具,结合HTTPS协议保障数据传输安全。

以下为TensorFlow服务器部署关键配置对比表:

| 配置项 | 基础配置 | 高性能配置 |

|---|---|---|

| GPU | 单卡RTX 3090 (24GB显存) | 4卡A100 (40GB显存,NVLink) |

| 内存 | 64GB DDR4 | 256GB DDR5 |

| 存储 | 1TB SATA SSD | 4TB NVMe RAID 0 |

| 分布式策略 | MirroredStrategy | MultiWorkerMirroredStrategy |

| 数据加载 | tf.data.Dataset + prefetch | tf.data + TFRecord +并行读取 |

| 监控工具 | TensorBoard | Prometheus + Grafana |

相关问答FAQs:

-

问:TensorFlow服务器如何处理显存不足的问题?

答:可通过以下方法缓解显存压力:① 使用混合精度训练(tf.keras.mixed_precision.set_global_policy('mixed_float16'));② 采用梯度累积技术,减少每步更新的batch size;③ 启用tf.config.experimental.set_memory_growth,动态分配显存;④ 模型分片或使用参数服务器(Parameter Server)架构进行分布式训练。 -

问:如何提升TensorFlow分布式训练的通信效率?

答:优化通信效率需从硬件和算法两方面入手:硬件上,使用支持RDMA的高速网卡(如InfiniBand)和NVLink连接GPU;算法上,选择合适的all_reduce策略(如NCCL的Hierarchical All-Reduce),调整tf.distribute.experimental.CommunicationOptions中的timeout和max_retries参数,并确保所有节点时钟同步(通过NTP服务),减少模型参数量或采用模型并行(如Pipeline Parallelism)也可降低通信开销。