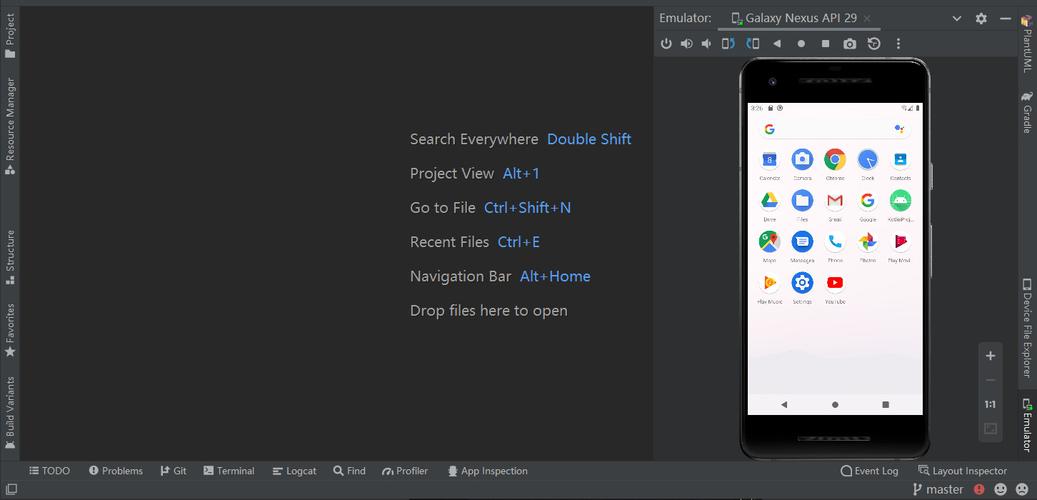

在移动应用开发领域,Android客户端与服务器之间的视频交互技术已成为核心需求之一,涵盖视频上传、实时预览、点播播放等多种场景,这一技术栈的实现不仅需要客户端高效的音视频处理能力,更依赖服务器端稳定的编解码、存储与分发机制,以下从技术架构、关键流程及优化方向三个维度展开详细分析。

技术架构与核心组件

Android客户端与服务器视频交互通常采用“客户端采集-服务器处理-客户端播放”的分层架构,各层功能及核心技术如下:

| 层级 | 核心功能 | 关键技术/协议 |

|---|---|---|

| Android客户端 | 视频采集(摄像头/屏幕)、编码、上传;视频播放(解码、渲染) | MediaRecorder(采集)、MediaCodec(编解码)、FFmpeg(跨平台处理)、ExoPlayer(播放) |

| 网络传输 | 低延迟、高可靠传输视频数据 | RTMP(实时流)、HTTP-FLV(点播)、WebRTC(超低延迟)、WebSocket(双向通信) |

| 服务器端 | 视频接收、存储、转码、分发;用户鉴权、流量管理 | Nginx-RTMP(流媒体服务)、FFmpeg(转码)、MinIO/OSS(对象存储)、CDN(内容分发) |

| 数据库 | 存储视频元数据(标题、路径、用户ID等)、用户信息 | MySQL/PostgreSQL(关系型)、MongoDB(非结构化) |

关键流程实现细节

视频上传流程

Android端通过MediaRecorder采集视频(支持H.264编码+AAC音频),封装为FLV或MP4格式后,通过HTTP POST或RTMP协议上传至服务器,上传过程中需注意:

- 分片上传:大文件分块(如5MB/片)上传,支持断点续传,通过

OkHttp或Retrofit实现; - 进度回调:利用

ContentObserver监听文件状态,实时更新上传进度至UI; - 错误处理:网络异常时自动重试,结合

ExponentialBackoff算法避免频繁请求。

服务器端接收后,使用FFmpeg进行转码(如转换为H.265以节省带宽),生成不同清晰度版本(1080P/720P/480P),并存储至分布式文件系统,元数据通过RESTful API存入数据库,返回视频URL供客户端调用。

视频播放流程

Android端播放主要依赖ExoPlayer,其优势在于支持自适应码率(ABR)和DRM加密,播放流程包括:

- URL解析:从服务器获取M3U8播放列表(HLS协议)或直接播放MP4文件;

- 缓存机制:

ExoPlayer内置磁盘缓存,减少重复加载; - 硬件解码:优先使用

MediaCodec的Surface模式,降低CPU占用。

对于实时视频(如直播),客户端通过WebRTC或RTMP拉取流,结合TextureView实现画面渲染,并同步显示聊天弹幕等互动信息。

性能优化与挑战

- 延迟控制:直播场景下,需优化编解码参数(如降低GOP大小)和网络传输协议(WebRTC延迟可低于500ms);

- 带宽适配:根据网络类型(WiFi/4G)动态调整码率,通过

ExoPlayer的TrackSelector实现; - 服务器扩展:高并发场景下,采用负载均衡(如Nginx)和边缘节点(CDN)分发,避免单点故障;

- 兼容性处理:针对不同Android版本(如Android 5.0以下不支持MediaCodec API),需封装兼容层。

相关问答FAQs

Q1:Android视频上传时如何解决大文件上传失败的问题?

A1:可通过分片上传+断点续传机制解决,具体步骤为:①将大文件分割为固定大小的块(如1MB);②每个块独立上传,携带文件唯一标识和分片序号;③服务器接收后按序合并;④上传中断时,客户端通过查询接口获取已上传分片,从断点处继续,可使用Retrofit的@Multipart注解实现分片上传,并结合ProgressResponseBody监听进度。

Q2:如何降低Android端视频播放的耗电量?

A2:优化播放器配置和系统行为可显著降低耗电:①优先使用硬件解码(MediaCodec.createDecoderType设置为TYPE_SURFACE);②禁用不必要的功能(如自动旋转、后台播放);③采用ExoPlayer的PlayerView并设置useController(false)减少UI渲染;④播放时降低屏幕亮度并缩短超时时间;⑤对于后台播放,使用AudioFocus管理音频焦点,避免重复唤醒CPU。